Digitale Demokratie statt Datendiktatur

Big Data, Nudging, Verhaltenssteuerung: Droht uns die Automatisierung der Gesellschaft durch Algorithmen und künstliche Intelligenz? Ein gemeinsamer Appell zur Sicherung von Freiheit und Demokratie.

Alles wird intelligent: Bald haben wir nicht nur Smartphones, sondern auch Smart Homes, Smart Factories und Smart Cities. Erwarten uns am Ende der Entwicklung Smart Nations und ein smarter Planet?

Bild vergrößernDirk Helbing

In der Tat macht das Gebiet der künstlichen Intelligenz atemberaubende Fortschritte. Insbesondere trägt es zur Automatisierung der Big-Data-Analyse bei. Künstliche Intelligenz wird nicht mehr Zeile für Zeile programmiert, sondern ist mittlerweile lernfähig und entwickelt sich selbstständig weiter. Vor Kurzem lernten etwa Googles DeepMind-Algorithmen autonom, 49 Atari-Spiele zu gewinnen. Algorithmen können nun Schrift, Sprache und Muster fast so gut erkennen wie Menschen und viele Aufgaben sogar besser lösen. Sie beginnen, Inhalte von Fotos und Videos zu beschreiben. Schon jetzt werden 70 Prozent aller Finanztransaktionen von Algorithmen gesteuert und digitale Zeitungsnews zum Teil automatisch erzeugt. All das hat radikale wirtschaftliche Konsequenzen: Algorithmen werden in den kommenden 10 bis 20 Jahren wohl die Hälfte der heutigen Jobs verdrängen. 40 Prozent der Top-500-Firmen werden in einem Jahrzehnt verschwunden sein.

Es ist absehbar, dass Supercomputer menschliche Fähigkeiten bald in fast allen Bereichen übertreffen werden – irgendwann zwischen 2020 und 2060. Inzwischen ruft dies alarmierte Stimmen auf den Plan. Technologievisionäre wie Elon Musk von Tesla Motors, Bill Gates von Microsoft und Apple-Mitbegründer Steve Wozniak warnen vor Superintelligenz als einer ernsten Gefahr für die Menschheit, vielleicht bedrohlicher als Atombomben. Ist das Alarmismus?

Größter historischer Umbruch seit Jahrzehnten

Fest steht: Die Art, wie wir Wirtschaft und Gesellschaft organisieren, wird sich fundamental ändern. Wir erleben derzeit den größten historischen Umbruch seit dem Ende des Zweiten Weltkriegs: Auf die Automatisierung der Produktion und die Erfindung selbstfahrender Fahrzeuge folgt nun die Automatisierung der Gesellschaft. Damit steht die Menschheit an einem Scheideweg, bei dem sich große Chancen abzeichnen, aber auch beträchtliche Risiken. Treffen wir jetzt die falschen Entscheidungen, könnte das unsere größten gesellschaftlichen Errungenschaften bedrohen.

In den 1940er Jahren begründete der amerikanische Mathematiker Norbert Wiener (1894-1964) die Kybernetik. Ihm zufolge lässt sich das Verhalten von Systemen mittels geeigneter Rückkopplungen (Feedbacks) kontrollieren. Schon früh schwebte manchen Forschern eine Steuerung von Wirtschaft und Gesellschaft nach diesen Grundsätzen vor, aber lange fehlte die nötige Technik dazu.

Heute gilt Singapur als Musterbeispiel einer datengesteuerten Gesellschaft. Was als Terrorismusabwehrprogramm anfing, beeinflusst nun auch die Wirtschafts- und Einwanderungspolitik, den Immobilienmarkt und die Lehrpläne für Schulen. China ist auf einem ähnlichen Weg (siehe Kasten am Ende des Textes). Kürzlich lud Baidu, das chinesische Äquivalent von Google, das Militär dazu ein, sich am China-Brain-Projekt zu beteiligen. Dabei lässt man so genannte Deep-Learning-Algorithmen über die Suchmaschinendaten laufen, die sie dann intelligent auswerten. Darüber hinaus ist aber offenbar auch eine Gesellschaftssteuerung geplant. Jeder chinesische Bürger soll laut aktuellen Berichten ein Punktekonto („Citizen Score“) bekommen, das darüber entscheiden soll, zu welchen Konditionen er einen Kredit bekommt und ob er einen bestimmten Beruf ausüben oder nach Europa reisen darf. In diese Gesinnungsüberwachung ginge zudem das Surfverhalten des Einzelnen im Internet ein – und das der sozialen Kontakte, die man unterhält (siehe „Blick nach China“).

Bild vergrößernBruno Frey

Mit sich häufenden Beurteilungen der Kreditwürdigkeit und den Experimenten mancher Onlinehändler mit individualisierten Preisen wandeln auch wir im Westen auf ähnlichen Pfaden. Darüber hinaus wird immer deutlicher, dass wir alle im Fokus institutioneller Überwachung stehen, wie etwa das 2015 bekannt gewordene „Karma Police“-Programm des britischen Geheimdienstes zur flächendeckenden Durchleuchtung von Internetnutzern demonstriert. Wird Big Brother nun tatsächlich Realität? Und: Brauchen wir das womöglich sogar im strategischen Wettkampf der Nationen und ihrer global agierenden Unternehmen?

Programmierte Gesellschaft, programmierte Bürger

Angefangen hat es scheinbar harmlos: Schon seit einiger Zeit bieten uns Suchmaschinen und Empfehlungsplattformen personalisierte Vorschläge zu Produkten und Dienstleistungen an. Diese beruhen auf persönlichen und Metadaten, welche aus früheren Suchanfragen, Konsum- und Bewegungsverhalten sowie dem sozialen Umfeld gewonnen werden. Die Identität des Nutzers ist zwar offiziell geschützt, lässt sich aber leicht ermitteln. Heute wissen Algorithmen, was wir tun, was wir denken und wie wir uns fühlen – vielleicht sogar besser als unsere Freunde und unsere Familie, ja als wir selbst. Oft sind die unterbreiteten Vorschläge so passgenau, dass sich die resultierenden Entscheidungen wie unsere eigenen anfühlen, obwohl sie fremde Entscheidungen sind. Tatsächlich werden wir auf diese Weise immer mehr ferngesteuert. Je mehr man über uns weiß, desto unwahrscheinlicher werden freie Willensentscheidungen mit offenem Ausgang.

Auch dabei wird es nicht bleiben. Einige Softwareplattformen bewegen sich in Richtung „Persuasive Computing„. Mit ausgeklügelten Manipulationstechnologien werden sie uns in Zukunft zu ganzen Handlungsabläufen bringen können, sei es zur schrittweisen Abwicklung komplexer Arbeitsprozesse oder zur kostenlosen Generierung von Inhalten von Internetplattformen, mit denen Konzerne Milliarden verdienen. Die Entwicklung verläuft also von der Programmierung von Computern zur Programmierung von Menschen.

Bild vergrößernRoberto V. Zicari

Diese Technologien finden auch in der Politik zunehmend Zuspruch. Unter dem Stichwort Nudging versucht man, Bürger im großen Maßstab zu gesünderem oder umweltfreundlicherem Verhalten „anzustupsen“ – eine moderne Form des Paternalismus. Der neue, umsorgende Staat interessiert sich nicht nur dafür, was wir tun, sondern möchte auch sicherstellen, dass wir das Richtige tun. Das Zauberwort ist „Big Nudging“, die Kombination von Big Data und Nudging (siehe „Big Nudging“). Es erscheint manchem wie ein digitales Zepter, mit dem man effizient durchregieren kann, ohne die Bürger in demokratische Verfahren einbeziehen zu müssen. Lassen sich auf diese Weise Partikularinteressen überwinden und der Lauf der Welt optimieren? Wenn ja, dann könnte man regieren wie ein weiser König, der mit einer Art digitalem Zauberstab die gewünschten wirtschaftlichen und gesellschaftlichen Ergebnisse quasi herbeizaubert.

Vorprogrammierte Katastrophen

Doch ein Blick in die relevante wissenschaftliche Literatur zeigt, dass eine gezielte Kontrolle von Meinungen im Sinne ihrer „Optimierung“ an der Komplexität des Problems scheitert. Die Meinungsbildungsdynamik ist voll von Überraschungen. Niemand weiß, wie der digitale Zauberstab, sprich die manipulative Nudging-Technik, richtig zu verwenden ist. Was richtig und was falsch ist, stellt sich oft erst hinterher heraus. So wollte man während der Schweinegrippeepidemie 2009 jeden zur Impfung bewegen. Inzwischen ist aber bekannt, dass ein bestimmter Prozentsatz der Geimpften von einer ungewöhnlichen Krankheit, der Narkolepsie, befallen wurde. Glücklicherweise haben sich nicht mehr Menschen impfen lassen!

Auch mag der Versuch, Krankenversicherte mit Fitnessarmbändern zu verstärkter Bewegung anzuregen, die Anzahl der Herz-Kreislauf-Erkrankungen reduzieren. Am Ende könnte es dafür aber mehr Hüftoperationen geben. In einem komplexen System wie der Gesellschaft führt eine Verbesserung in einem Bereich fast zwangsläufig zur Verschlechterung in einem anderen. So können sich großflächige Eingriffe leicht als schwer wiegende Fehler erweisen.

Unabhängig davon würden Kriminelle, Terroristen oder Extremisten den digitalen Zauberstab früher oder später unter ihre Kontrolle bringen – vielleicht sogar ohne dass es uns auffällt. Denn: Fast alle Unternehmen und Einrichtungen wurden schon gehackt, selbst Pentagon, Weißes Haus und Bundestag. Hinzu kommt ein weiteres Problem, wenn ausreichende Transparenz und demokratische Kontrolle fehlen: die Aushöhlung des Systems von innen. Denn Suchalgorithmen und Empfehlungssysteme lassen sich beeinflussen. Unternehmen können bestimmte Wortkombinationen ersteigern, die in den Ergebnislisten bevorzugt angezeigt werden. Regierungen haben wahrscheinlich Zugriff auf eigene Steuerungsparameter. Bei Wahlen wäre es daher im Prinzip möglich, sich durch Nudging Stimmen von Unentschlossenen zu sichern – eine nur schwer nachweisbare Manipulation. Wer auch immer diese Technologie kontrolliert, kann also Wahlen für sich entscheiden, sich sozusagen an die Macht nudgen.

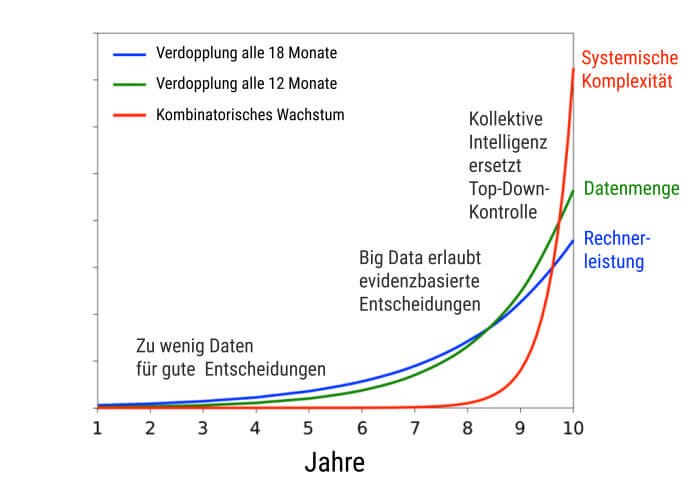

Bild vergrößernDigitales Wachstum

Verschärft wird dieses Problem durch die Tatsache, dass in Europa eine einzige Suchmaschine einen Marktanteil von rund 90 Prozent besitzt. Sie könnte die Öffentlichkeit maßgeblich beeinflussen, womit Europa vom Silicon Valley aus quasi ferngesteuert würde. Auch wenn das Urteil des Europäischen Gerichtshofs vom 6. Oktober 2015 nun den ungezügelten Export europäischer Daten einschränkt, ist das zu Grunde liegende Problem noch keineswegs gelöst, sondern erst einmal nur geografisch verschoben.

Mit welchen unerwünschten Nebenwirkungen ist zu rechnen? Damit Manipulation nicht auffällt, braucht es einen so genannten Resonanzeffekt, also Vorschläge, die ausreichend kompatibel zum jeweiligen Individuum sind. Damit werden lokale Trends durch Wiederholung allmählich verstärkt, bis hin zum „Echokammereffekt“: Am Ende bekommt man nur noch seine eigenen Meinungen widergespiegelt. Das bewirkt eine gesellschaftliche Polarisierung, also die Entstehung separater Gruppen, die sich gegenseitig nicht mehr verstehen und vermehrt miteinander in Konflikt geraten. So kann personalisierte Information den gesellschaftlichen Zusammenhalt unabsichtlich zerstören. Das lässt sich derzeit etwa in der amerikanischen Politik beobachten, wo Demokraten und Republikaner zusehends auseinanderdriften, so dass politische Kompromisse kaum noch möglich sind. Die Folge ist eine Fragmentierung, vielleicht sogar eine Zersetzung der Gesellschaft.

Einen Meinungsumschwung auf gesamtgesellschaftlicher Ebene kann man wegen des Resonanzeffekts nur langsam und allmählich erzeugen. Die Auswirkungen treten mit zeitlicher Verzögerung ein, lassen sich dann aber auch nicht mehr einfach rückgängig machen. So können zum Beispiel Ressentiments gegen Minderheiten oder Migranten leicht außer Kontrolle geraten; zu viel Nationalgefühl kann Diskriminierung, Extremismus und Konflikte verursachen. Noch schwerer wiegt der Umstand, dass manipulative Methoden die Art und Weise verändern, wie wir unsere Entscheidungen treffen. Sie setzen nämlich die sonst bedeutsamen kulturellen und sozialen Signale außer Kraft – zumindest vorübergehend. Zusammengefasst könnte der großflächige Einsatz manipulativer Methoden also schwer wiegende gesellschaftliche Schäden verursachen, einschließlich der ohnehin schon verbreiteten Verrohung der Verhaltensweisen in der digitalen Welt. Wer soll dafür die Verantwortung tragen?

Rechtliche Probleme

Bild vergrößernErnst Hafen

Dies wirft rechtliche Fragen auf, die man angesichts der Milliardenklagen gegen Tabakkonzerne, Banken, IT- und Automobilunternehmen in den vergangenen Jahren nicht vernachlässigen sollte. Doch welche Gesetze werden überhaupt tangiert? Zunächst einmal ist klar, dass manipulative Technologien die Entscheidungsfreiheit einschränken. Würde die Fernsteuerung unseres Verhaltens perfekt funktionieren, wären wir im Grunde digitale Sklaven, denn wir würden nur noch fremde Entscheidungen ausführen. Bisher funktionieren manipulative Technologien natürlich nur zum Teil. Jedoch verschwindet unsere Freiheit langsam, aber sicher – langsam genug, dass der Widerstand der Bürger bisher noch gering war.

Die Einsichten des großen Aufklärers Immanuel Kant scheinen jedoch hochaktuell zu sein. Unter anderem stellte er fest, dass ein Staat, der das Glück seiner Bürger zu bestimmen versucht, ein Despot ist. Das Recht auf individuelle Selbstentfaltung kann nur wahrnehmen, wer die Kontrolle über sein Leben hat. Dies setzt jedoch informationelle Selbstbestimmung voraus. Es geht hier um nicht weniger als unsere wichtigsten verfassungsmäßig garantierten Rechte. Ohne deren Einhaltung kann eine Demokratie nicht funktionieren. Ihre Einschränkung unterminiert unsere Verfassung, unsere Gesellschaft und den Staat.

Da manipulative Technologien wie Big Nudging ähnlich wie personalisierte Werbung funktionieren, sind noch weitere Gesetze tangiert. Werbung muss als solche gekennzeichnet werden und darf nicht irreführend sein. Auch sind nicht alle psychologischen Tricks wie etwa unterschwellige Reize erlaubt. So ist es untersagt, ein Erfrischungsgetränk im Kinofilm für eine Zehntelsekunde einzublenden, weil die Werbung dann nicht bewusst wahrnehmbar ist, während sie unterbewusst vielleicht eine Wirkung entfaltet. Das heute gängige Sammeln und Verwerten persönlicher Daten lässt sich außerdem nicht mit dem geltendem Datenschutzrecht in europäischen Ländern vereinen.

Bild vergrößernMichael Hagner

Schließlich steht auch die Rechtmäßigkeit personalisierter Preise in Frage, denn es könnte sich dabei um einen Missbrauch von Insiderinformationen handeln. Hinzu kommen mögliche Verstöße gegen den Gleichbehandlungsgrundsatz, das Diskriminierungsverbot und das Wettbewerbsrecht, da freier Marktzugang und Preistransparenz nicht mehr gewährleistet sind. Die Situation ist vergleichbar mit Unternehmen, die ihre Produkte in anderen Ländern billiger verkaufen, jedoch den Erwerb über diese Länder zu verhindern versuchen. In solchen Fällen gab es bisher empfindliche Strafzahlungen.

Mit klassischer Werbung oder Rabattmarken sind personalisierte Werbung und Preise nicht vergleichbar, denn Erstere sind unspezifisch und dringen auch bei Weitem nicht so sehr in unsere Privatsphäre ein, um unsere psychologischen Schwächen auszunutzen und unsere kritische Urteilskraft auszuschalten. Außerdem gelten in der akademischen Welt selbst harmlose Entscheidungsexperimente als Versuche am Menschen und bedürfen der Beurteilung durch eine Ethikkommission, die der Öffentlichkeit Rechenschaft schuldet. Die betroffenen Personen müssen in jedem einzelnen Fall ihre informierte Zustimmung geben. Absolut unzureichend ist dagegen ein Klick zur Bestätigung, dass man einer 100-seitigen Nutzungsbedingung pauschal zustimmt, wie es bei vielen Informationsplattformen heutzutage der Fall ist.

Dennoch experimentieren manipulative Technologien wie Nudging mit Millionen von Menschen, ohne sie darüber in Kenntnis zu setzen, ohne Transparenz und ohne ethische Schranken. Selbst große soziale Netzwerke wie Facebook oder Onlinedating-Plattformen wie OK Cupid haben sich bereits öffentlich zu solchen sozialen Experimenten bekannt. Wenn man unverantwortliche Forschung an Mensch und Gesellschaft vermeiden möchte (man denke etwa an die Beteiligung von Psychologen an den Folterskandalen der jüngsten Vergangenheit), dann benötigen wir dringend hohe Standards, insbesondere wissenschaftliche Qualitätskriterien und einen ethischen Kodex analog zum hippokratischen Eid.

Wurden unser Denken, unsere Freiheit, unsere Demokratie gehackt?

Bild vergrößernYvonne Hofstetter

Angenommen, es gäbe eine superintelligente Maschine, die quasi gottgleiches Wissen und übermenschliche Fähigkeiten hätte – würden wir dann ehrfürchtig ihren Anweisungen folgen? Das erscheint durchaus möglich. Aber wenn wir das täten, dann hätten sich die Befürchtungen von Elon Musk, Bill Gates, Steve Wozniak, Stephen Hawking und anderen bewahrheitet: Computer hätten die Kontrolle über die Welt übernommen. Es muss uns klar sein, dass auch eine Superintelligenz irren, lügen, egoistische Interessen verfolgen oder selbst manipuliert werden kann. Vor allem könnte sie sich nicht mit der verteilten, kollektiven Intelligenz der Bevölkerung messen.

Das Denken aller Bürger durch einen Computercluster zu ersetzen, wäre absurd, denn das würde die Qualität der erreichbaren Lösungen dramatisch verschlechtern. Schon jetzt ist klar, dass sich die Probleme in der Welt trotz Datenflut und Verwendung personalisierter Informationssysteme nicht verringert haben – im Gegenteil! Der Weltfrieden ist brüchig. Die langfristige Veränderung des Klimas könnte zum größten Verlust von Arten seit dem Aussterben der Dinosaurier führen. Die Auswirkungen der Finanzkrise auf Wirtschaft und Gesellschaft sind sieben Jahre nach ihrem Beginn noch lange nicht bewältigt. Cyberkriminalität richtet einen jährlichen Schaden von drei Billionen Dollar an. Staaten und Terroristen rüsten zum Cyberkrieg.

Bild vergrößernAndrej Zwitter

In einer sich schnell verändernden Welt kann auch eine Superintelligenz nie perfekt entscheiden – die Datenmengen wachsen schneller als die Prozessierbarkeit, und die Übertragungsraten sind begrenzt. So werden lokales Wissen und Fakten außer Acht gelassen, die jedoch von Bedeutung sind, um gute Lösungen zu erzielen. Verteilte, lokale Steuerungsverfahren sind zentralen Ansätzen oft überlegen, vor allem in komplexen Systemen, deren Verhalten stark variabel, kaum voraussagbar und nicht in Echtzeit optimierbar ist. Das gilt schon für die Ampelsteuerung in Städten, aber noch viel mehr für die sozialen und ökonomischen Systeme unserer stark vernetzten, globalisierten Welt.

Weiterhin besteht die Gefahr, dass die Manipulation von Entscheidungen durch mächtige Algorithmen die Grundvoraussetzung der „kollektiven Intelligenz“ untergräbt, die sich an die Herausforderungen unserer komplexen Welt flexibel anpassen kann. Damit kollektive Intelligenz funktioniert, müssen Informationssuche und Entscheidungsfindung der Einzelnen unabhängig erfolgen. Wenn unsere Urteile und Entscheidungen jedoch durch Algorithmen vorgeben werden, führt das im wahrsten Sinne des Wortes zur Volksverdummung. Vernunftbegabte Wesen werden zu Befehlsempfängern degradiert, die reflexhaft auf Stimuli reagieren. Das reduziert die Kreativität, weil man weniger „out of the box“ denkt.

Bild vergrößernJeroen van den Hoven

Anders gesagt: Personalisierte Information baut eine „filter bubble“ um uns herum, eine Art digitales Gedankengefängnis. In letzter Konsequenz würde eine zentrale, technokratische Verhaltens- und Gesellschaftssteuerung durch ein superintelligentes Informationssystem eine neue Form der Diktatur bedeuten. Die von oben gesteuerte Gesellschaft, die unter dem Banner des „sanften Paternalismus“ daherkommt, ist daher im Prinzip nichts anderes als ein totalitäres Regime mit rosarotem Anstrich.

In der Tat zielt „Big Nudging“ auf die Gleichschaltung vieler individueller Handlungen und auf eine Manipulation von Sichtweisen und Entscheidungen. Dies rückt es in die Nähe der gezielten Entmündigung des Bürgers durch staatlich geplante Verhaltenssteuerung. Wir befürchten, dass die Auswirkungen langfristig fatal sein könnten, insbesondere wenn man die oben erwähnte, teils kulturzerstörende Wirkung bedenkt.

Eine bessere digitale Gesellschaft ist möglich

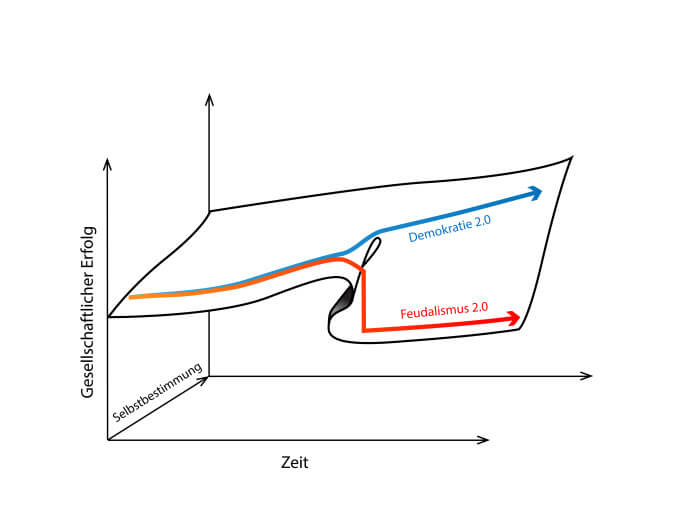

Bild vergrößernAm digitalen Scheideweg

Trotz des harten globalen Wettbewerbs tun Demokratien gut daran, ihre in Jahrhunderten erarbeiteten Errungenschaften nicht über Bord zu werfen. Gegenüber anderen politischen Regimes haben die westlichen Demokratien den Vorteil, dass sie mit Pluralismus und Diversität bereits umzugehen gelernt haben. Jetzt müssen sie nur noch stärker davon profitieren lernen.

In Zukunft werden jene Länder führend sein, die eine gute Balance von Wirtschaft, Staat und Bürgern erreichen. Dies erfordert vernetztes Denken und den Aufbau eines Informations-, Innovations-, Produkte- und Service-„Ökosystems“. Hierfür ist es nicht nur wichtig, Beteiligungsmöglichkeiten zu schaffen, sondern auch Vielfalt zu fördern. Denn es gibt keine Methode, um zu ermitteln, was die beste Zielfunktion ist: Soll man das Bruttosozialprodukt optimieren oder Nachhaltigkeit? Macht oder Frieden? Lebensdauer oder Zufriedenheit? Oft weiß man erst hinterher, was vorteilhaft gewesen wäre. Indem sie verschiedene Ziele zulässt, ist eine pluralistische Gesellschaft besser in der Lage, mit verschiedenen Herausforderungen zurechtzukommen.

Zentralisierte Top-down-Kontrolle ist eine Lösung der Vergangenheit, die sich nur für Systeme geringer Komplexität eignet. Deshalb sind föderale Systeme und Mehrheitsentscheidungen die Lösungen der Gegenwart. Mit der wirtschaftlichen und kulturellen Entwicklung nimmt die gesellschaftliche Komplexität jedoch weiter zu. Die Lösung der Zukunft lautet kollektive Intelligenz: Citizen Science, Crowd Sourcing und Online-Diskussionsplattformen sind daher eminent wichtige neue Ansätze, um mehr Wissen, Ideen und Ressourcen nutzbar zu machen.

Bild vergrößernGerd Gigerenzer

Kollektive Intelligenz benötigt einen hohen Grad an Diversität. Diese wird jedoch durch heutige personalisierte Informationssysteme zu Gunsten der Verstärkung von Trends reduziert. Soziodiversität ist genauso wichtig wie Biodiversität. Auf ihr beruhen nicht nur kollektive Intelligenz und Innovation, sondern auch gesellschaftliche Resilienz – also die Fähigkeit, mit unerwarteten Schocks zurechtzukommen. Die Verringerung der Soziodiversität reduziert oft auch die Funktions- und Leistungsfähigkeit von Wirtschaft und Gesellschaft. Dies ist der Grund, warum totalitäre Regimes oft in Konflikte mit ihren Nachbarn geraten. Typische Langzeitfolgen sind politische Instabilitäten und Kriege, wie sie in unserer Geschichte immer wieder auftraten. Pluralität und Partizipation sind also nicht in erster Linie als Zugeständnisse an die Bürger zu sehen, sondern als maßgebliche Funktionsvoraussetzungen leistungsfähiger, komplexer, moderner Gesellschaften.

Zusammenfassend kann man sagen: Wir stehen an einem Scheideweg. Big Data, künstliche Intelligenz, Kybernetik und Verhaltensökonomie werden unsere Gesellschaft prägen – im Guten wie im Schlechten. Sind solche weit verbreiteten Technologien nicht mit unseren gesellschaftlichen Grundwerten kompatibel, werden sie früher oder später großflächigen Schaden anrichten. So könnten sie zu einer Automatisierung der Gesellschaft mit totalitären Zügen führen. Im schlimmsten Fall droht eine zentrale künstliche Intelligenz zu steuern, was wir wissen, denken und wie wir handeln. Jetzt ist daher der historische Moment, den richtigen Weg einzuschlagen und von den Chancen zu profitieren, die sich dabei bieten. Wir fordern deshalb die Einhaltung folgender Grundprinzipien:

- die Funktion von Informationssystemen stärker zu dezentralisieren;

- informationelle Selbstbestimmung und Partizipation zu unterstützen;

- Transparenz für eine erhöhte Vertrauenswürdigkeit zu verbessern;

- Informationsverzerrungen und -verschmutzung zu reduzieren;

- von den Nutzern gesteuerte Informationsfilter zu ermöglichen;

- gesellschaftliche und ökonomische Vielfalt zu fördern;

- die Fähigkeit technischer Systeme zur Zusammenarbeit zu verbessern;

- digitale Assistenten und Koordinationswerkzeuge zu erstellen;

- kollektive Intelligenz zu unterstützen; und

- die Mündigkeit der Bürger in der digitalen Welt zu fördern – eine „digitale Aufklärung“.

Mit dieser Agenda würden wir alle von den Früchten der digitalen Revolution profitieren: Wirtschaft, Staat und Bürger gleichermaßen. Worauf warten wir noch?

Lesen Sie mehr: Eine Strategie für das digitale Zeitalter – der Aktionsplan

Frey, B. S. und Gallus, J.: Beneficial and Exploitative Nudges. In: Economic Analysis of Law in European Legal Scholarship. Springer, 2015.

Gallagher, R.: Profiled: From Radio to Porn, British Spies Track Web Users’ Online Identities. In: The Intercept, 25.09.2015.

Gigerenzer, G.: On the Supposed Evidence for Libertarian Paternalism. In: Review of Philosophy and Psychology 6(3), S. 361-383, 2015.

Gigerenzer, G.: Risiko: Wie man die richtigen Entscheidungen trifft. Bertelsmann, 2013.

Hafen, E. und Brauchbar, M.: Befreiung aus der digitalen Leibeigenschaft. In: Neue Zürcher Zeitung, 05.03.2014.

Hafen, E., Kossmann, D. und Brand, A.: Health data cooperatives – citizen empowerment. In: Methods of Information in Medicine 53(2), S. 82–86, 2014.

Han, B.-C.: .: Psychopolitik: Neoliberalismus und die neuen Machttechniken. S. Fischer, 2014.

Harris, S.: The Social Laboratory. In: Foreign Policy, 29.07.2014.

Helbing, D.: The Automation of Society Is Next: How to Survive the Digital Revolution. CreateSpace, 2015.

Helbing, D.: Societal, Economic, Ethical and Legal Challenges of the Digital Revolution: From Big Data to Deep Learning, Artificial Intelligence, and Manipulative Technologies. Jusletter IT, 2015.

Helbing, D.: Thinking Ahead – Essays on Big Data, Digital Revolution, and Participatory Market Society. Springer, 2015.

Helbing, D. und Pournaras, E.: Build Digital Democracy. In: Nature 527, S. 33-34, 2015.

Hofstetter, Y.: Sie wissen alles: Wie intelligente Maschinen in unser Leben eindringen und warum wir für unsere Freiheit kämpfen müssen. Bertelsmann, 2014.

Köhler, T. R.: Der programmierte Mensch. Wie uns Internet und Smartphone manipulieren. Frankfurter Allgemeine Buch, 2012.

Koops, B.-J., Oosterlaken, I., Romijn, H., Swierstra, T. und van den Hoven, J.: Responsible Innovation 2. Concepts, Approaches, and Applications. Springer, 2015.

Medina, E.: Cybernetic Revolutionaries. MIT Press, 2011.

Schirrmacher, F.: Technologischer Totalitarismus – Eine Debatte. Suhrkamp, 2015.

Schlieter, K.: Die Herrschaftsformel. Wie Künstliche Intelligenz uns berechnet, steuert und unser Leben verändert. Westend, 2015.

Storm, D.: ACLU: Orwellian Citizen Score, China’s credit score system, is a warning for Americans. Computerworld, 07.10.2015.

Tucker, P.: Can the military make a prediction machine? Defense One, 08.04.2015.

van den Hoven, J., Vermaas, P.E. und van den Poel, I.: Handbook of Ethics, Values and Technological Design. Springer, 2015.

Volodymyr, M., Kavukcuoglu, K., Silver, D., et al.: Human-level control through deep reinforcement learning. In: Nature, 518, S. 529-533, 2015.

Zicari, R. und Zwitter, A.: Data for Humanity: An Open Letter. Frankfurt Big Data Lab, 13.07.2015.

Zwitter, A.: Big Data Ethics. In: Big Data & Society 1(2), 2014.